schraubenking

Gut bekanntes Mitglied

Hallo Zusammen,

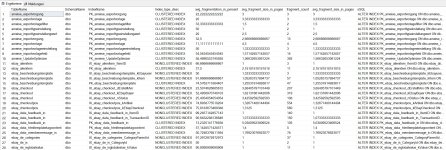

Da wir nun seit ~2011 mit WAWI arbeiten, haben sich in vielen Tabellen Einträge aus der Urzeit gesammelt, welche die SQL DB unnötig aufblasen und daher hab ich mir mal die größten Tabellen rausgesucht.

tbestellpos ....1.768GB

tArtikelhistory ...742MB

tPicklistePos ...535MB

tWarenLagerAusgang....373MB

.....

und viele andere mehr, die zu einer recht großen DB beitragen und dazu führen, dass die Nutzung (trotz vernünftiger Infrastruktur) recht mühsam wird.

Jetzt meine Fragen:

a) tPicklistePos und auch die tPicklistePosStatus: hier hab ich in der ..Pos Tabelle fast 3 Mio Einträge ! Da wir jedoch WMS nicht nutzen und ich auch sonst keine Möglichkeit kenne im Wawi (nach Pickliste liefern) auf eine alte Pickliste zuzugreifen, könnte man diese Tabellen nicht einfach bis zu einem bestimmten Stichtag (z.B. 01.01.2019) entleeren.

b) tbestellpos: eigentlich gleiche Geschichte...mich interessiert nicht was vor 12 Jahren im einzelnen bestellt wurde und lt. Aufbewahrungspflichten für das Finanzamt, sind auch nur 7 Jahre vorzuhalten.

Dies gilt übrigens auch für die Tabellen tWarenLagerAusgang und auch tArtikelhistory

Da wir den Server bereits wöchtenlich neu starten und auch die WAWI DB Verwaltung fast täglich laufen lassen, jedoch das Arbeiten immer mühsamer wird, überlege ich solche Schritte um das System wieder zu beschleunigen.

Auf eine höhere Version möchte ich aktuell noch nicht umstellen, da ich von vielen Performance Problemen gelesen hab und die 1.5.55er für uns eigentlich alles bieten was wir benötigen.

Gibt es hierzu Tipps bzw. hat sowas schon mal wer gemacht ?

Ich bedanke mich im Voraus für eure Beiträge.

Markus

Da wir nun seit ~2011 mit WAWI arbeiten, haben sich in vielen Tabellen Einträge aus der Urzeit gesammelt, welche die SQL DB unnötig aufblasen und daher hab ich mir mal die größten Tabellen rausgesucht.

tbestellpos ....1.768GB

tArtikelhistory ...742MB

tPicklistePos ...535MB

tWarenLagerAusgang....373MB

.....

und viele andere mehr, die zu einer recht großen DB beitragen und dazu führen, dass die Nutzung (trotz vernünftiger Infrastruktur) recht mühsam wird.

Jetzt meine Fragen:

a) tPicklistePos und auch die tPicklistePosStatus: hier hab ich in der ..Pos Tabelle fast 3 Mio Einträge ! Da wir jedoch WMS nicht nutzen und ich auch sonst keine Möglichkeit kenne im Wawi (nach Pickliste liefern) auf eine alte Pickliste zuzugreifen, könnte man diese Tabellen nicht einfach bis zu einem bestimmten Stichtag (z.B. 01.01.2019) entleeren.

b) tbestellpos: eigentlich gleiche Geschichte...mich interessiert nicht was vor 12 Jahren im einzelnen bestellt wurde und lt. Aufbewahrungspflichten für das Finanzamt, sind auch nur 7 Jahre vorzuhalten.

Dies gilt übrigens auch für die Tabellen tWarenLagerAusgang und auch tArtikelhistory

Da wir den Server bereits wöchtenlich neu starten und auch die WAWI DB Verwaltung fast täglich laufen lassen, jedoch das Arbeiten immer mühsamer wird, überlege ich solche Schritte um das System wieder zu beschleunigen.

Auf eine höhere Version möchte ich aktuell noch nicht umstellen, da ich von vielen Performance Problemen gelesen hab und die 1.5.55er für uns eigentlich alles bieten was wir benötigen.

Gibt es hierzu Tipps bzw. hat sowas schon mal wer gemacht ?

Ich bedanke mich im Voraus für eure Beiträge.

Markus