der_Martin

Sehr aktives Mitglied

Hi,

wir sind vor einiger Zeit von Shop 4 auf 5 umgestiegen. Nun habe ich in der Google Konsole zufällig festgestellt, das Google 1,8 Millionen Shopseiten nicht indexiert!

WHAT???!!!

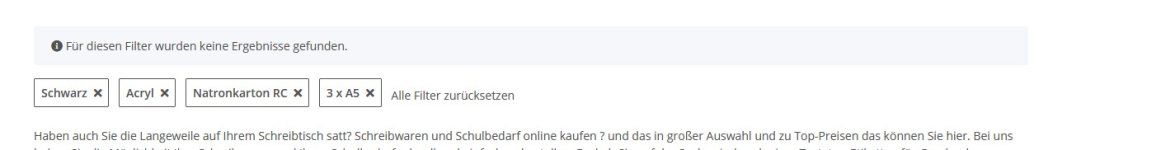

Das Problem: Google scheint einige Filterwerte zu followen. Und der Bot produziert sich daraus lustige Filter-Kombinationen, die alle eine eigene URL erhalten.... Millionen!!!

Ich halte es für einen Template Bug im Nova....

Während nämlich normal anklickbare Filterwerte ein rel=nofollow haben, wie es sein soll, kann ich das nofollow bei Dropdown Filtern im Code des Anchor Tags nicht finden (????).

Und ich hab auf manchen Seiten viele Dropdown-Filter https://yerd.de/YERD-Saegeketten ... dazu kommen die Merkmalwert-Seite, die diese Dropdowns auch haben.

Obwohl die Filterseiten wohl auf noindex stehen, folgt und crawlt der Bot diese also. Etwa 1,8mio Seiten aktuell....

Ich hab in den Admin-Einstellungen Merkmalwert-URLs auf "index" stehen. Aber das betrifft ja wohl nur die Merkmal-Seiten, die ich zwingend indexieren möchte!!!!! Die sind sehr wichtig für mich. Auch die Links von den Artikeldetailseiten zu den Merkmalseiten sollen natürlich auf follow stehen. Aber nicht etwa dass zusammen-geklickte Filter-Kombinationen gefollowed werden. Da bekomme ich endlos duplizierten Content und z.T. völlig sinnlose Seiten....

Wie gesagt: Da die normalen Anklick-Filter ein nofollow haben, die Dropdown-Filter aber wohl nicht, sehe ich darin den Fehler...

Kann mir jemand sagen, wo ich das fixen kann. Oder hat jemand eine Idee, wieso Google plötzlich Millionen URLs crawlt und produziert.....???

Grüße

Martin

wir sind vor einiger Zeit von Shop 4 auf 5 umgestiegen. Nun habe ich in der Google Konsole zufällig festgestellt, das Google 1,8 Millionen Shopseiten nicht indexiert!

WHAT???!!!

Das Problem: Google scheint einige Filterwerte zu followen. Und der Bot produziert sich daraus lustige Filter-Kombinationen, die alle eine eigene URL erhalten.... Millionen!!!

Ich halte es für einen Template Bug im Nova....

Während nämlich normal anklickbare Filterwerte ein rel=nofollow haben, wie es sein soll, kann ich das nofollow bei Dropdown Filtern im Code des Anchor Tags nicht finden (????).

Und ich hab auf manchen Seiten viele Dropdown-Filter https://yerd.de/YERD-Saegeketten ... dazu kommen die Merkmalwert-Seite, die diese Dropdowns auch haben.

Obwohl die Filterseiten wohl auf noindex stehen, folgt und crawlt der Bot diese also. Etwa 1,8mio Seiten aktuell....

Ich hab in den Admin-Einstellungen Merkmalwert-URLs auf "index" stehen. Aber das betrifft ja wohl nur die Merkmal-Seiten, die ich zwingend indexieren möchte!!!!! Die sind sehr wichtig für mich. Auch die Links von den Artikeldetailseiten zu den Merkmalseiten sollen natürlich auf follow stehen. Aber nicht etwa dass zusammen-geklickte Filter-Kombinationen gefollowed werden. Da bekomme ich endlos duplizierten Content und z.T. völlig sinnlose Seiten....

Wie gesagt: Da die normalen Anklick-Filter ein nofollow haben, die Dropdown-Filter aber wohl nicht, sehe ich darin den Fehler...

Kann mir jemand sagen, wo ich das fixen kann. Oder hat jemand eine Idee, wieso Google plötzlich Millionen URLs crawlt und produziert.....???

Grüße

Martin