Hallo zusammen,

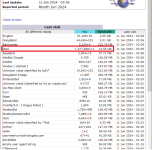

wir beobachten bei einem Kunden eine ungewoehnlich hohe CPU-Aulastung durch den MySQL-Dienst.

Die restlichen Dienste (Apache, PHP-FPM, Redis) sind im entspannten Bereich.

Uebliche Optimierungen an der MySQL-Config haben wir bereits vorgenommen.

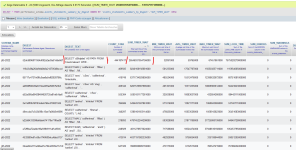

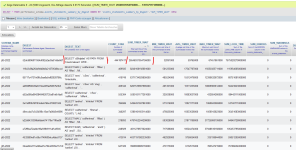

Bei der Analyse der Queries sticht uns einer ins Auge:

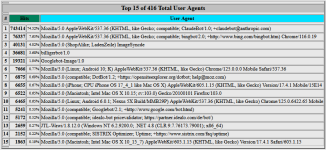

Insgesamt scheinen die Abfragen in Richtung Merkmale fuer einen Grossteil der Last verantwortlich zu sein.

Ist das bei euch auch so?

Laesst sich das optimieren?

LG

wir beobachten bei einem Kunden eine ungewoehnlich hohe CPU-Aulastung durch den MySQL-Dienst.

Die restlichen Dienste (Apache, PHP-FPM, Redis) sind im entspannten Bereich.

Uebliche Optimierungen an der MySQL-Config haben wir bereits vorgenommen.

Bei der Analyse der Queries sticht uns einer ins Auge:

SQL:

SELECT `cBildpfad` AS PATH FROM `tmerkmalwert` WHE...Insgesamt scheinen die Abfragen in Richtung Merkmale fuer einen Grossteil der Last verantwortlich zu sein.

Ist das bei euch auch so?

Laesst sich das optimieren?

LG